НЛП — это… Что такое НЛП?

НЛП — Аббревиатура Нейролингвистическое программирование. Краткий толковый психолого психиатрический словарь. Под ред. igisheva. 2008 … Большая психологическая энциклопедия

НЛП — Аббревиатура Нейролингвистическое программирование … Универсальный дополнительный практический толковый словарь И. Мостицкого

НЛП — Нейролингвистическое программирование (НЛП) (англ. Neuro linguistic programming) (также встречается вариант «нейро лингвистическое программирование») комплекс моделей, техник и операционных принципов (контекстуально зависимых убеждений),… … Википедия

Нлп — Нейролингвистическое программирование (НЛП) (англ. Neuro linguistic programming) (также встречается вариант «нейро лингвистическое программирование») комплекс моделей, техник и операционных принципов (контекстуально зависимых убеждений),… … Википедия

НЛП — Аббревиатура Нейролингвистическое программирование … Словарь нейролингвистического программирования

НЛП — (эн эл пи)(нейро лингвистическое программирование) 1. Теория о взаимодействии человека с окружающим миром посредством внутреннего программирования. 2. Дисциплина, занимающаяся моделированием (выявлением, формализацией) и передачей… … Учебный словарь терминов рекламы и паблик рилейшенз

Теория о взаимодействии человека с окружающим миром посредством внутреннего программирования. 2. Дисциплина, занимающаяся моделированием (выявлением, формализацией) и передачей… … Учебный словарь терминов рекламы и паблик рилейшенз

НЛП — Национально либеральная партия (Ливан) национально либеральная партия нейролингвистическая психология нейролингвистическое программирование … Словарь сокращений русского языка

НЛП (значения) — НЛП: Нейролингвистическое программирование Наплавной лёгкий парк … Википедия

НЛП и наука — Одна из статей на тему Нейролингвистическое программирование (НЛП) Основные статьи НЛП · Принципы · История Новый код · НЛП и наука · Библиография Принципы и методы Раппорт · Рефрейминг · Милтон модель Репрезентативные системы · Нейрологические… … Википедия

Пресуппозиции НЛП — Эта статья о понятии нейролингвистического программирования. О термине в лингвистической семантике см. Пресуппозиция. Одна из статей на тему Нейролингвистическое программирование (НЛП) Основные статьи НЛП · Принципы · История … Википедия

О термине в лингвистической семантике см. Пресуппозиция. Одна из статей на тему Нейролингвистическое программирование (НЛП) Основные статьи НЛП · Принципы · История … Википедия

Нейролингвистическое программирование (НЛП) — презентация онлайн

1. Семинар 1_1 ПСД11-о

Выполнила:Котко Людмила Владимировна

2. Нейролингвистическое программирование (НЛП).

Система НЛП быларазработана с целью

выявления паттернов

в работе

выдающихся

специалистов в

области психологии,

и применения их

опыта, как синтеза

эффективных техник

на практике.

Ричард Бэндлер, 1950 г.р.

Джо Гриндер, 1940 г.р.

3. Специалистами, чей опыт было решено преобразовать в модели были:

Вирджиния Сатир (семейныйтерапевт),

Милтон Эриксон (эриксоноский

гипноз),

Фриц Перлз (гештальттерапевт).

4. Расшифровка термина НЛП.

«Нейро» — поведение берет начало вслушания, восприятия запаха, вкуса,

прикосновения и ощущения.

Мы

Мывоспринимаем мир через пять своих

органов чувств

«Лингвистическое» – язык как средство

коммуникации.

«Программирование» – способы

организации идей и действий для

получения результата.

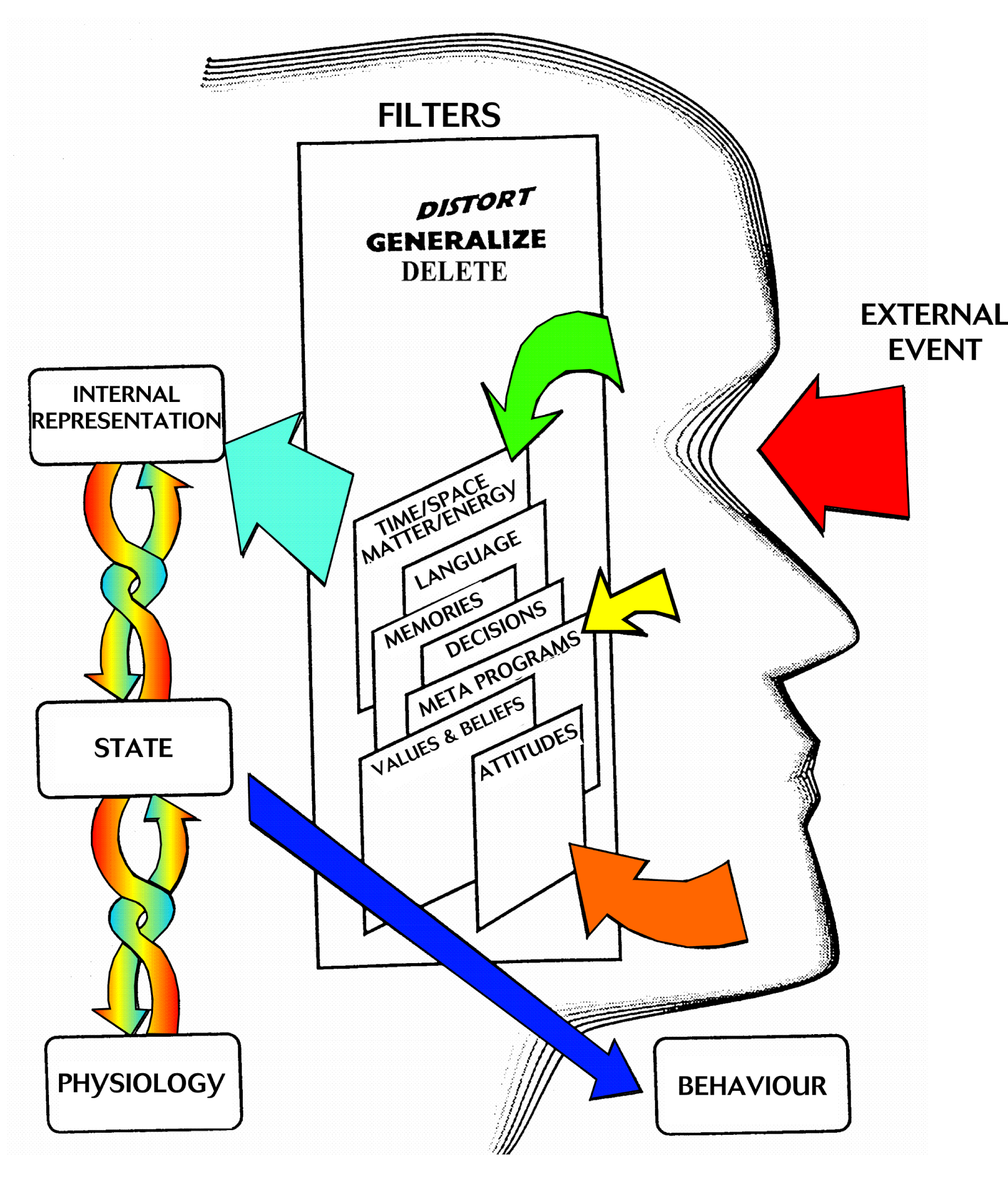

5. Карты и Фильтры

Карта – это не территория, которую онаописывает.

Мы обращаем внимание на те аспекты

мира, которые нас интересуют. и

игнорируем другие. Мир всегда богаче,

чем те идеи, которые мы имеем

относительно его.

6. Карты и Фильтры

Фильтрывосприятия

Социальный

фильтр

фильтр

НейроФизиологический

фильтр

7. Фильтры восприятия.

«Как выглядит кусок хлеба, зависит от того,голодны вы или сыты» (Арабская поговорка).

Нейрофизиологический фильтр (зрение,

слух, осязание, обоняние, вкус),

Социальный фильтр (язык,

национальность, обычаи, обряды, история

народа и государства, и др.),

Индивидуальный фильтр (мысли,

эмоции, черты характера, интересы,

привычки, симпатии, антипатии, способы

поведения, реакции, и т.

д.).

д.).8. Поведенческие рамки

Ориентация на результат, а не напроблемы. Поиск того, к чему

стремишься, поиск решений и их

использование для продвижения к цели.

возникла эта проблема? Чья это ошибка?».

Вопрос «Как?» (понимание структуры

проблемы) вместо «Почему?» (поиск

причин и оправданий).

9. Поведенческие рамки

Обратная связь вместо неудачи.Нет неудачи – есть только результаты. Вы

можете использовать полученные

результаты для того, чтобы

скорректировать направление приложения

своих усилий. Обратная связь удерживает

цель в поле вашего зрения.

Рассматривать возможность, а не

необходимость. Сосредоточьтесь на том,

что вы можете сделать, на имеющихся

возможностях, а не на ограничивающих

вас обстоятельствах.

10. Поведенческие рамки

Позиция любопытства и удивлениявзамен притворства. Маленькие дети

помогает их любопытство.

Все мы имеем или можем создать

внутренние ресурсы, необходимые нам

для достижения наших целей. Вы с

большей вероятностью добьетесь успеха,

если будете действовать в предположении.

как будто это верно, нежели предполагая

обратное.

11. Основные мысли НЛП

Карта не соответствует местности.Опыт имеет свою структуру. Чтобы

изменить опыт, нужно поменять образец и

структуру.

Разум и тело – едины.

Все в природе взаимосвязано.

Если один человек смог сделать что-то, то

и любой другой сможет.

создать.

12. Основные мысли НЛП

Человеческое поведение имеет некоторуюцель.

Позитивное намерение в поведении

человека.

Подсознание благожелательно к нам.

Человек совершает лучший из возможных

выборов, наилучшим образом.

Иметь выбор лучше чем не иметь.

Обучение происходит через действие.

13. Основные мысли НЛП

Если вам не удается то, что вы делаете, сделайтечто-либо другое.

14. Области применения НЛП

ОтношенияВлияние на сознание масс

Переговоры,

общение

Маркетинг

Обучение

Постановка целей

психосоматика

Личностный

рост

15. Четыре стадии научения:

1. Неосознанное незнание2. Осознанное незнание

3. Осознанное знание

4. Неосознанное знание

Процесс забывания — это переход от п. 4 к

п. 2. Процесс переучивания — это переход

от п. 2 обратно к п. 4, но уже с большим

количеством выборов. Мы исследуем

различные модели научения чуть позже.

Мы способны сознательно ухватить лишь

очень маленький кусочек из того объема

информации, который мир предлагает нам,

неосознанно мы реагируем и замечаем

значительно больше, чем осознаем.

Эта идея была подчеркнута в 1956 году

американским психологом Джорджем

число семь, плюс-минус два?»

Наше подсознание — это все

жизнеобеспечивающие процессы нашего

организма, все то, чему мы уже научились,

наш прошлый опыт и все то, что мы могли бы

заметить, но не замечаем в настоящий

момент.

Подсознание является значительно

Подсознание является значительноболее осведомленным, чем сознание.

17. Источники информации:

«Джозеф О’Коннор, Ян Мак-ДермоттПринципы NLP»

«С.Андреас и др. Миссия НЛП»

нлп, нейро лингвистическое программирование

нлп

НЛП

Расшифровка.

НЛП — эта аббревиатура стала довольно распространённой в наше время. Что же она значит? Расшифровываются эти три буквы, как нейро-лингвистическое программирование.

Откуда же взялось это название? По одной из версии Джон Гриндер и Ричард Бэндлер — основатели модели НЛП — заперлись в бревенчатой избушке, что в Калифорнийских горах и поставили себе вопрос: «Как же назвать придуманный нами метод?». Гриндер — по образованию лингвист, а Бэндлер – математик и программист. И их объединяло занятие по исследованию возможностей мышления и психофизиологии, поэтому они объединили в название этого метода три его ключевых звена:

Нейро — то есть определяет путь использования наших органов чувств.

Лингвистическое — определяет связь между языком, используемым человеком, и его жизненным опытом. То есть наши лексические модели показывают наш образ мышления и, можно сказать, наш внутренний мир.

Программирование — помогает исследовать и изменять переживания и опыт.

Зарождение.

В середине семидесятых на психотерапевтическую сцену взошли два молодых человека — Джон Гриндер и Ричард Бэндлер, которые начали обучать новому методу воздействия на человека, его поведение и ощущения. Новое программное течение, несмотря на поддержку таких звёзд, как Сатир, Эриксон и Бэйтсон, полностью игнорировалось академическими представителями. Однако вне стен университетов НЛП нашло широкий отклик в применении. Кроме того, НЛП продолжало исследования в области коммуникаций, и поэтому НЛП развивалось как коммуникативная модель.

Что даёт НЛП?

НЛП помогает скорее и результативнее достигать своих целей. Эффективные приёмы общения в духе НЛП позволяют быстрее добиваться взаимопонимания у окружающих. При этом активизируются те умственные способности, о которых вы даже не подозревали.

Наконец, благодаря нему можно научится управлять состоянием своего разума и психики.

Такой уровень самоконтроля приносит уверенность в себе и повышает самооценку. Более того, НЛП открывает более неординарный и творческий подход к решению любых проблем.

НЛП уделяет практике гораздо больше внимания, чем теории. Как правило, новички замечают, что суть теории открывается только после применения приёма.

И напоследок, НЛП – это то, благодаря чему поразительные скрытые возможности системы «разум-тело» становятся реальностью. НЛП предлагает структуру, которая поможет упрочнить ваше сознание, привить ему привычку достигать обозначенных целей.

Автор: Ольга Пашкевич

для сайта therapy. by

by

Эрик Берн — НЛП-Практика

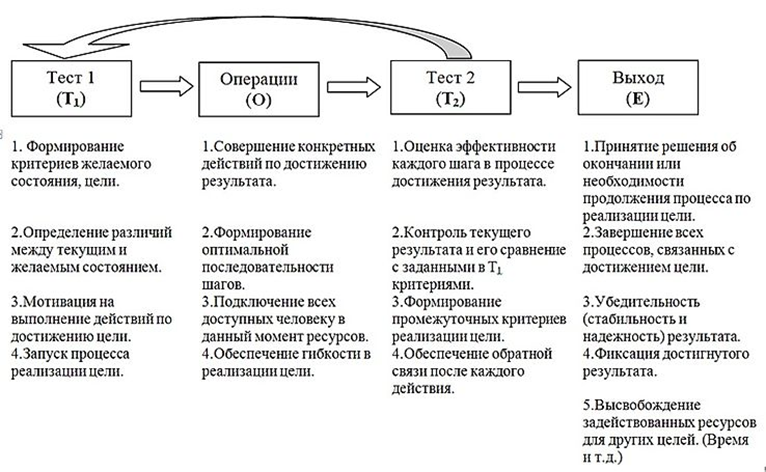

НЛ-Программирование (1) Пять шагов программы

Мы метапрактики считаем, что термин «нейро-лингвистическое программирование» выбран в качестве титульного наименования направления деятельности совсем не случайно. Разумеется, здесь есть и аллюзии на термин “parental programming” невероятно популярного в то время Эрика Берна (и тут же «принцы» и «лягушки»), и отсылки к фундаментальному (по словам Бэндлера) труду Альфреда Коржибского (я писал об этом несколько раз). Метанимус видит в термине «программирование» буквальную метафору и указывает, что в любой нл-программе должна быть своя алгоритмическая составляющая с шагами, циклами, тестами и возвратами. Мы разделяем это его утверждение. Тем не менее, считаем, что метафора программирования как деятельности должна быть расшифрована и истолкована. Это наполнит абстрактные паруса термина полезными пресуппозициями и придаст метафоре программирования больше жизненности. Для нас же это будет полезной тренировкой в распознавании подобия (изоморфизма) и пресуппозиций. В целом такая расшифровка будет еще и утилизацией метафоры. Читать далее НЛ-Программирование (2) Необходимость расшифровки метафоры

В целом такая расшифровка будет еще и утилизацией метафоры. Читать далее НЛ-Программирование (2) Необходимость расшифровки метафоры

Периодически на меня находит желание поисследовать, откуда есть-пошло НЛП. Этакая психолого-историческая археология. Вслед за А. Ткачёвым я придерживаюсь точки зрения, что само название «нейро-лингвистическое программирование» имеет не случайное происхождение (как это последовательно утверждает Дж. Гриндер) а намеренное, и несёт в себе пресуппозиции работы самого метода, притом, это название следует понимать буквально.

На страницах журнала Метапракик мы уже разбирали термин «нейро-лингвистический». Как мы знаем, пришёл он из работы Альфреда Коржибского «Наука и психическое здоровье». С истоками термина «программирование» ясно не до конца. Во-первых, математическое образование Ричарда Бэндлера. Во-вторых, влияние известного (и гремевшего на всю Америку) тогда Эрика Берна. В книге, в которой его идеи получали максимальное развитие («What do you say after you say hello», в русском переводе «Люди, которые играют в игры»), мы встречаем термин «родительское программирование», parental programming. На мой взгляд, создатели НЛП успешно, вполне по-эриксониански использовали (utilized) идеи Берна и их известность, в частности, придали техническое содержание его термину «программирование». Читать далее НЛ-Программирование (1) Пять шагов программы

На мой взгляд, создатели НЛП успешно, вполне по-эриксониански использовали (utilized) идеи Берна и их известность, в частности, придали техническое содержание его термину «программирование». Читать далее НЛ-Программирование (1) Пять шагов программы

Помню давно, когда я пришел в Метапрактик, я подхватил знамёна «радикального НЛП». По аналогии со Скиннером и его «радикальным бихевиоризмом». Если есть в чем-то и нейрологическая компонента, и лингвистическая, и алгоритмическая, — значит, тут есть НЛП, и это стоит обсуждать. Нет — уж извольте. И будучи настроенным на такой лад, я все время изумлялся пиетету Метанимуса относительно трансакционного анализа. Для меня наследие Эрика Берна представлялось даже не в утрированной форме, оно представлялось мне неправильно. Меня воротило даже не от описания игр, а хотя бы даже от сценариев — как это так, думал я, чтобы пара родительских внушений определила последующую жизнь человека! Бред! А еще БиГи в своих книгах критиковали трансакционный анализ. В общем, для себя я объяснял это метанимусовской сентиментальностью — ведь он начинал свой путь в психологии именно из ТА. Читать далее Про Эрика Берна замолвлю я слово

В общем, для себя я объяснял это метанимусовской сентиментальностью — ведь он начинал свой путь в психологии именно из ТА. Читать далее Про Эрика Берна замолвлю я слово

Расшифровка… — Винницкий Центр НЛП и эриксоновского гипноза

Треугольник Карпмана: Спаситель-Жертва-Палач

(Преследователь): Вина, Праведность и другие симптомы. «Одна из прекрасных практичных моделей, созданных школой транзактного анализа, наряду со знаменитым «я ОК — ты ОК» и пр.

Знание самой модели совсем не гарантирует, что в эти игры то и дело не включаешься. Да, есть правила, которые от этих «психологических игр второго порядка» отводят, предохраняют. Но я — и не будда какой-нибудь, живущий в постоянной осознанности, и не подозрительно-начекушный параноик.

Так что время от времени ойкаю уже задним числом. Или — чаще — проскочил попытку поиграть со мной вместе, те самые правильные установки автоматически сработали. Или — ой, я в игре, — ну как мальчик!))

Страшного тут ничего нет, главное действительно быстро сообразить, что ты в шаги по треугольнику включился, и быстренько выскакивать.

И маркер тут, когда ты внутри ситуации, — чувства.

Похоже, сильные, «чистые» (беспримесные до ненатуральности) чувства плюс их переключения («драматическая перипетия») — основные сыр и мёд этой ловушки.

Многие путают этот компот с полнотой жизни и любовью: чего-чего, а страстей тут навалом. — А, Дом-2, конечно!))

Так вот: с транзктным анализом знаком поверхностно, наверняка для себя велосипед изобрёл, ну так не в научный журнал и пишу.

Верные мгновенные сигналы, что ты вляпался, нужно «очнуться», распознать игру (расклад ролей прямо сейчас) и немедленно из неё выходить.

1. Вина! Чувство вины — полезнейший маркер, что ты — в треугольнике. Подозреваю, что, как говорят в медицине, патогномоничный (т.е. симптом, который встречается исключительно при одном заболевании и сразу позволяет его диагностировать).

2. Ощущение своей праведности, своей полноправной правоты, ликующее такое, пышущее. — Увы, туда же. Насчёт патогномоничности не знаю; но если и есть какие-то здоровые проявления, то они очень на краю. Против фашистов — о, да! — …а кого в этом сезоне считаем фашистами?..

Против фашистов — о, да! — …а кого в этом сезоне считаем фашистами?..

Ооот трижды осторожно; высочайшая вероятность на этом чувстве, что ты — там, в игре, и на следующем ходу (а ты, кстати, кто сейчас? Спаситель или Палач? шансы, так-то, 50/50, но это и не имеет значения) — и на следующем ходу роль твоя драматически сменится, и это скоро.

Почему ещё и — «Драматический треугольник».

3. Третье чувство-маркер – чувство использованности. Что ты-то со всей душой, а вышло, что тебя – использовали. Обошлись как с вещью. Попользовались – и с равнодушием, или раздражением, или прочим неблагодарным фырканьем отбросили.

4. Четвёртое чувство-маркер — стремление помочь, подставить плечо, взять на буксир… «Бойся первого движения души: оно всегда благородно». Точно, что не уникально для треугольника Карпмана. Но очень скользко, «благими намерениями дорога в ад вымощена». Признак, что именно маркер треугольника – не просто стремление помочь, а вот именно окраска «как-же-ж-иначе-ж!!»

Сам очень склонен в этой точке, Спасителем, в треугольник въезжать.

Поэтому

— три правила «неигровой» помощи.

1. Человек сам прямо просит о помощи. Не намекает, прямо просит!

2. Ты хочешь помочь ему больше, чем не хочешь. Никаких «должен». Это вопрос о том, чего ХОЧЕШЬ больше.

3. Человек для помощи себе использует хотя бы не меньше (в норме — больше!) сил, времени, энергии, чем ты для помощи ему.

Если хотя бы одно из этих трёх условий не соблюдается — ты в игре.

Можешь, — отчего бы нет, — но будь готов к интригующей и «неожиданной» смене ролей. — Я за то, что можно делать всё, если понимаешь, зачем это делаешь)

Подводя итог:

«Треугольник Карпмана» — крайне распространённый вариант манипулятивных психологических игр, в которых участники даже не отдают себе отчёт, «что их так крутит».

Есть четыре маркерных чувства, которые – ура! – позволяют «в моменте» распознать, что ты в игре.

А тогда уже быстро сориентироваться и выйти. Это вина, праведность, использованность, неодолимое стремление помочь «как-же-ж-иначе-ж».

Всё это не означает, что людям «не надо» помогать. Но есть три условия неигровой помощи. Если нарушено хотя бы одно из них – вы в игре. Это тоже можно, но хотя бы понимай, что делаешь своими руками – и принимай ответственность за последствия»

автор текста и фото

Расшифровка странного названияРасшифровка странного названияВесной 1976 года Джон и Ричард спрятались в бревенчатом домике высоко в горах неподалеку от Санта Круза, собирая вместе все прозрения и открытия, которые они сделали. К концу марафона, который длился 36 часов, они открыли бутылку красного калифорнийского вина и спросили сами себя: «Как это будет называться?» В результате получилось Нейро-Лингвистическое программирование -громоздкое словосочетание, за которым скрываются три простые идеи. Нейро – говорит об отношении к мышлению или чувственному восприятию – к процессам, протекающим в нервной системе и играющим важную роль в формировании человеческого поведения, а также к нейрологическим процессам в сфере восприятия – зрения, слуха, тактильных ощущений, вкуса и обоняния. Существенная часть НЛП связана с пониманием и использованием принципов и паттернов нервной системы. Согласно НЛП, мышление, память, творчество, создание мысленных образов и все остальные когнитивные процессы являются результатом выполнения определенных программ внутри нервной системы человека. Человеческий опыт представляет собой комбинацию или синтез информации, которую мы получаем и обрабатываем с помощью нервной системы. На практике это связано с восприятием мира через чувства: зрение, осязание, слух, обоняние и вкус. Лингвистическое указывает на то, что нервные процессы кодируются, упорядочиваются и получают значение посредством языка, коммуникативных систем и различных символических систем (грамматики, математики, музыки, изображений). С точки зрения НЛП, язык в некотором смысле является продуктом нервной системы, однако при этом стимулирует и формирует деятельность самой нервной системы. С уверенностью можно сказать, что язык представляет собой один из основных способов, которым один человек может активировать или стимулировать нервную систему других людей. Таким образом, эффективное общение и взаимодействие связаны с использованием языка для обучения, стимуляции и вербализации понятий, целей и проблем применительно к той или иной задаче или ситуации. В НЛП мы говорим о двух основных языковых системах. Во-первых, «сознание» обрабатывает информацию в терминах изображений, звуков, тактильных и вкусовых ощущений и запахов (сенсорная информация) посредством «репрезентативных систем». Сутью НЛП является установление контроля над своим собственным сознанием. Программирование относится к нашей способности организовывать эти части (изображения, звуки, тактильные и вкусовые ощущения, запахи и символы или слова) в нашем «сознании-теле», что затем позволяет нам достигать желаемых результатов. Эти части образуют программы, которые выполняет наш мозг. В основе НЛП лежит представление о том, что обучение, память и творчество являются функциями определенных нейро-лингвистических программ, которые с большей или меньшей эффективностью служат выполнению определенных задач или достижению определенных результатов. Иными словами, мы как человеческие существа осуществляем взаимодействие с окружающим миром посредством внутреннего программирования. Мы реагируем на проблемы и воспринимаем новые идеи согласно тому типу психических программ, который создали внутри себя, – а эти программы далеко не одинаковы. Некоторые программы или стратегии являются более эффективными для осуществления того или иного вида деятельности, чем другие. Программирование – указывает на тот способ, при помощи которого мы организовываем наше мышление, включая чувства и убеждения, чтобы в конечном итоге достичь поставленных целей – подобно тому, как мы используем компьютер для решения каких–либо конкретных задач при помощи соответствующего программного обеспечения. НЛП имеет дело со структурой субъективного опыта человека: как мы организуем то, что видим, слышим и ощущаем, и как мы редактируем и фильтруем с помощью органов чувств то, что получаем из внешнего мира. НЛП также исследует то, как мы описываем это в языке и как мы действуем — намеренно или ненамеренно — чтобы получить результат. Гриндер и Бандлер назвали эти модели «нейролингви-стическим программированием», так как считали, что такое название определяет сущность открытого ими явления. Мы сообщаем о своих ощущениях себе и другим двумя следующими способами: 1. Через нашу нервную систему, то есть мы с помощью разума «переводим» ощущение в психику. Примером этого может быть то, как наше тело и выражение лица отражают такую эмоцию, как восхищение, даже если мы стараемся этого не показывать. 2. Через язык, то есть с помощью особых слов и формул, описывая что-либо. Например, разница между высказываниями «Я не хочу учиться водить машину» и «Я хочу научиться летать». Вдобавок, мы учимся реагировать определенным образом на конкретные ситуации и развивать автоматические модели или программы – и на уровне нервной системы, и на уровне языка. Например, в большинстве из нас заложена программа здороваться с хорошими знакомыми, которая включает в себя то, как мы произносим приветствие, как движемся и как физически реагируем на них, и даже выражение нашего лица. Такие программы составляют большинство наших ежедневных реакций на самого себя, на других и на наше окружение, они считаются нашей личностью, нашей жизнью, просто нашим «Я». Обычно мы не останавливаемся на том, чтобы обдумать эти реакции, пока они не доставляют нам значительных проблем. Однако НЛП призывает нас осознать свои модели поведения и общения. Изучая и разъясняя модели превосходства, исследователи НЛП предложили нам структуру переосмысления своих моделей общения с самим собой и другими людьми. Исследователи НЛП приводят доказательства того, что все модели, которыми мы бессознательно пользуемся, на самом деле были усвоены нами и развиты благодаря наблюдению за другими и личному опыту. Однако, по их мнению, при желании мы можем пересмотреть свои образцы поведения и сознательно их НЛП показывает нам, как опознать свои автоматические реакции, чтобы узнать, как мы влияем на других, добиваясь определенных реакций и конкретного поведения. Мы можем выбрать, какие модели применять, чтобы активизировать собственное превосходство, а не надеяться, что оно появиться, когда будет в этом необходимость. Также мы можем заменить неподходящие модели, научиться превращать свое превосходство в автоматические программы и приобретать те модели, которые советуют исследователи НЛП. НЛП – это инструкция по применению великолепного компьютера, именуемого нашим разумом, которая дает нам возможность наиболее продуктивно им пользоваться.

|

Институт НеоКода – Новый код НЛП

личные инструменты

Вы посетили: • GROW

Модель GROW создана Джоном Уитмором как модель эффективных вопросов и является наиболее распространённым способом структурирования беседы в коучинге. Обычно вопросы задают, чтобы получить информацию. Однако в данном случае информация имеет второстепенное значение. Полученные ответы часто задают направление последующих вопросов, позволяя в то же время контролировать, следует ли клиент выбранному пути, который совпадает с целями коучинга. Как правило, это открытые вопросы, требующие описательных ответов, а не осуждения, поэтому риск впасть в самокритику или нанести ущерб самолюбию клиента отсутствует. Открытые вопросы способствуют осознанию и как следствие ответственности у клиента. Важно чтобы вопросы отвечали интересам клиента, следуя за ходом его мыслей.

Аббревиатура GROW означает ключевые точки, через которые стоит провести клиента и которые являются:

Goal — Расстановка целей, определение целей на короткий и длительный срок.

Reality — Обследование текущей ситуации на реальность.

Options — Определение списка возможностей и стратегии плана действий.

Way/Will — Намерения. «Что, когда, кем и ради чего?» будет делаться.

Ccылки по теме

Вопросы для GROW

Goal

Oписывает желаемый результат.

Это действительно цель или просто мечта?

Моя цель — из разряда «хочу» или «надо»?

Чувствую ли я воодушевление при мысли о цели?

К какой высшей цели ведет моя цель?

Конфликтует ли эта цель с чем-то еще? Другими целями, ценностями, убеждениями?

Каковы риски в случае достижения цели?

Что я потеряю, если не достигну цели?

Находится ли моя цель в зоне моей компетенции и контроля?

Конкретен ли язык, на котором описана цель?

Измерима ли моя цель?

Привязана ли к дате?

Позитивна ли?

Есть ли конкретный момент, когда я пойму, что достиг цели?

Reality

Описывает текущую ситуацию и ресурсы.

Описана ли реальность в тех же терминах, что и цель?

Включил ли я факты и цифры, где нужно?

Включил ли я допущения?

Пытался ли я уже раньше достичь цели?

Если да, то что не получалось?

Какие мнения и оценки содержатся в описании реальности?

Включил ли я описание своих чувств по поводу ситуации?

Какими ресурсами (включая навыки, контакты, информацию и т.д.) я располагаю?

Делал ли я что-либо подобное до этого?

Знаю ли я шаги, которые приведут меня к достижению цели?

На сколько процентов (шагов) выполнена цель?

Obstacles

Описывает препятствия на пути достижения цели.

Что не дает мне достичь цели?

Откуда я знаю, что это именно оно?

Что может еще помешать? (непрерывно спрашивайте себя)

Требуется ли мне изменить себя для достижения цели?

Что не дает мне измениться?

Насколько я доверяю себе в процессе?

Каковы риски в процессе достижения цели?

Это реальные риски или самооправдание?

Делаю ли я что-то прямо или косвенно для поддержания ситуации в ее текущем виде?

Есть ли у меня убеждения о том, как я должен реагировать на такого рода ситуации?

Считаю ли я, что у ситуации есть исторические причины?

Мешает ли мне кто-то? Как конкретно?

С какой целью они это делают?

Не мешает ли мне окружение в достижении цели?

Что нужно изменить в моем окружении, что поможет?

Каких ресурсов у меня нет? Способностей, навыков, информации?

Options

Описывает вариант действия.

Каков самый простой путь?

Каков может быть первый шаг?

Если бы все было возможно, что бы я сделал?

Каково идеальное решение?

Как создать ресурс, которого не хватает?

Кто может поделиться ресурсами?

На что можно обменять какие ресурсы?

Где может быть нужная информация?

Где научиться нужному навыку?

Как найти на все это время?

Был ли у меня опыт решения подобных проблем?

Что я делал в прошлом?

Что я уже делаю, что работает на достижение цели?

Существует ли проверенный способ решения таких проблем?

Знаю ли я кого-то, кто хорошо справится с такого рода препятствиями?

Есть ли какие-то группы или люди, которые готовы мне помочь?

Какие ошибки уже совершены другими до меня, которые мне совершать не обязательно?

Что на самом деле замотивирует меня?

Что принесет мне смена восприятия?

Что бы я сделал, если был более или менее настойчивым и упертым?

Как я могу изменить свою реакцию на ситуацию или человека?

По каким правилам я работаю? Откуда они взялись?

Могу ли я как-то решить эту проблему способом, который совершенно мне не свойственен?

Хватает ли мне вариантов?

Нужно ли мне устранять все препятствия?

Есть ли возможность временного решения?

Way (Will)

Описывает путь достижения результата.

Каков первый шаг, который я должен предпринять?

Каков будет второй шаг?

Знаю ли я, каким будет последний шаг?

Могу ли я мысленно пройти обратно, от последнего до первого шага?

Является ли шаг реалистичным?

Рассмотрел ли я все варианты?

Является ли мой шаг смелым?

Может ли первый шаг быть креативным?

Как мне сохранить мотивацию до конца пути?

Кто может поддержать меня на пути? (Вариант «никто» не принимается)

Куда я могу обратиться за поддержкой в первую очередь? В последнюю очередь?

На кого повлияют мои шаги? Кого я должен проинформировать?

Как я справлюсь с негативной реакцией других?

По десятибальной шкале, насколько я уверен в осуществлении плана? Что нужно сделать, чтобы быть более уверенным?

Есть ли у меня конкретные опасения по поводу моей способности осуществить план? Как я могу с ними справиться?

У всех ли шагов есть даты?

Доволен ли я в целом планом?

Как я отпраздную завершение?

Как реализовать декодер поиска луча для обработки естественного языка

Последнее обновление 3 июня 2020 г.

Задачи обработки естественного языка, такие как создание заголовков и машинный перевод, включают создание последовательностей слов.

Модели, разработанные для этих проблем, часто работают, генерируя распределения вероятностей по словарю выходных слов, и именно алгоритмы декодирования выбирают распределения вероятностей для генерации наиболее вероятных последовательностей слов.

В этом руководстве вы откроете для себя алгоритмы декодирования жадного поиска и поиска луча, которые можно использовать для решения задач генерации текста.

После прохождения этого руководства вы будете знать:

- Проблема декодирования по задачам генерации текста.

- Алгоритм декодера жадного поиска и как его реализовать на Python.

- Алгоритм декодера поиска луча и как его реализовать на Python.

Начните свой проект с моей новой книги «Глубокое обучение для обработки естественного языка», включая пошаговые руководства и файлы исходного кода Python для всех примеров.

Приступим.

- Обновление май / 2020 : Исправлена ошибка в реализации поиска луча (спасибо всем, кто указал на это, и Константину Вайссеру за его чистое исправление)

Как реализовать декодер поиска луча для обработки естественного языка

Фотография See1, Do1, Teach2, некоторые права защищены.

Декодер для генерации текста

В задачах обработки естественного языка, таких как создание заголовков, обобщение текста и машинный перевод, требуется предсказание последовательности слов.

Модели, разработанные для этих типов задач, обычно выводят распределение вероятностей по каждому слову в словаре для каждого слова в выходной последовательности. Затем процесс декодирования преобразует вероятности в окончательную последовательность слов.

Вы, вероятно, столкнетесь с этим при работе с повторяющимися нейронными сетями в задачах обработки естественного языка, где текст генерируется в качестве вывода. Последний уровень в модели нейронной сети имеет по одному нейрону для каждого слова в выходном словаре, а функция активации softmax используется для вывода вероятности того, что каждое слово в словаре будет следующим словом в последовательности.

Декодирование наиболее вероятной выходной последовательности включает поиск по всем возможным выходным последовательностям на основе их правдоподобия. Размер словарного запаса часто составляет десятки или сотни тысяч слов или даже миллионы слов. Следовательно, проблема поиска экспоненциальна по длине выходной последовательности и трудноразрешима (NP-полная) для полного поиска.

На практике методы эвристического поиска используются для возврата одной или нескольких приближенных или «достаточно хороших» декодированных выходных последовательностей для данного предсказания.

Поскольку размер поискового графа экспоненциально зависит от длины исходного предложения, мы должны использовать приближения, чтобы найти решение эффективно.

— стр. 272, Справочник по обработке естественного языка и машинному переводу, 2011 г.

Последовательности слов-кандидатов оцениваются на основе их правдоподобия. Обычно для поиска последовательностей текста-кандидатов используют жадный поиск или поиск по лучу. Мы рассмотрим оба этих алгоритма декодирования в этом посте.

Каждое индивидуальное предсказание имеет ассоциированную оценку (или вероятность), и нас интересует выходная последовательность с максимальной оценкой (или максимальной вероятностью) […] Одним из популярных приближенных методов является использование жадного предсказания, при котором на каждом этапе берется элемент с наивысшей оценкой. Хотя этот подход часто бывает эффективным, он явно неоптимален. Действительно, использование лучевого поиска в качестве приблизительного поиска часто работает намного лучше, чем жадный подход.

— страница 227, Методы нейронных сетей в обработке естественного языка, 2017.

Нужна помощь с глубоким обучением текстовых данных?

Пройдите мой бесплатный 7-дневный ускоренный курс электронной почты (с кодом).

Нажмите, чтобы зарегистрироваться, а также получите бесплатную электронную версию курса в формате PDF.

Начните БЕСПЛАТНЫЙ ускоренный курс прямо сейчас

Декодер жадного поиска

Простое приближение — использовать жадный поиск, который выбирает наиболее подходящее слово на каждом шаге выходной последовательности.

Преимущество этого подхода в том, что он очень быстр, но качество конечных выходных последовательностей может быть далеко от оптимального.

Мы можем продемонстрировать подход к декодированию с помощью жадного поиска на небольшом надуманном примере на Python.

Мы можем начать с задачи прогнозирования, которая включает последовательность из 10 слов. Каждое слово прогнозируется как распределение вероятностей по словарю из 5 слов.

# определяем последовательность из 10 слов над словарём из 5 слов данные = [[0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0.4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1]] data = массив (данные)

# определить последовательность из 10 слов в словаре из 5 слов data = [[0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1 , 0,2, 0,3, 0.4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [ 0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1]] данные = массив (данные) |

Предположим, что слова были закодированы в целое число, так что индекс столбца можно использовать для поиска связанного слова в словаре.Следовательно, задача декодирования становится задачей выбора последовательности целых чисел из распределений вероятностей.

Математическая функция argmax () может использоваться для выбора индекса массива, имеющего наибольшее значение. Мы можем использовать эту функцию для выбора индекса слова, который наиболее вероятен на каждом этапе последовательности. Эта функция предоставляется непосредственно в numpy.

Приведенная ниже функция greedy_decoder () реализует эту стратегию декодирования с помощью функции argmax.

# жадный декодер def greedy_decoder (данные): # индекс наибольшей вероятности для каждой строки return [argmax (s) для s в данных]

# жадный декодер def greedy_decoder (data): # индекс наибольшей вероятности для каждой строки return [argmax (s) для s в данных] |

Собрав все это вместе, полный пример, демонстрирующий жадный декодер, приведен ниже.

из массива импорта numpy из numpy import argmax # жадный декодер def greedy_decoder (данные): # индекс наибольшей вероятности для каждой строки return [argmax (s) для s в данных] # определяем последовательность из 10 слов над словарём из 5 слов данные = [[0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0.1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1]] данные = массив (данные) # декодировать последовательность результат = greedy_decoder (данные) print (результат)

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 18 19 20 21 22 23 | из массива импорта numpy из массива импорта numpy argmax # жадный декодер def greedy_decoder (data): # индекс для наибольшей вероятности каждой строки return [argmax (s) для s в данных] # определить последовательность из 10 слов в словаре из 5 слов data = [[0.1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1]] данные = массив (данные) # последовательность декодирования результат = greedy_decoder (данные) печать (результат) |

При выполнении примера выводится последовательность целых чисел, которая затем может быть снова отображена на слова в словаре.

[4, 0, 4, 0, 4, 0, 4, 0, 4, 0]

[4, 0, 4, 0, 4, 0, 4, 0, 4, 0] |

Декодер поиска луча

Еще одна популярная эвристика — поиск по лучу, который расширяет жадный поиск и возвращает список наиболее вероятных выходных последовательностей.

Вместо того, чтобы жадно выбирать наиболее вероятный следующий шаг при построении последовательности, поиск луча расширяет все возможные следующие шаги и сохраняет k наиболее вероятным, где k является параметром, задаваемым пользователем и управляет количеством лучей или параллельный поиск по последовательности вероятностей.

Алгоритм поиска локального луча отслеживает k состояний, а не только одно. Он начинается с k случайно сгенерированных состояний. На каждом шаге генерируются все преемники всех k состояний. Если какая-либо цель является целью, алгоритм останавливается. В противном случае он выбирает k лучших последователей из полного списка и повторяет.

— страницы 125-126, Искусственный интеллект: современный подход (3-е издание), 2009 г.

Нам не нужно начинать со случайных состояний; вместо этого мы начинаем с k наиболее вероятных слов в качестве первого шага в последовательности.

Общие значения ширины луча: 1 для жадного поиска и значения 5 или 10 для общих проблем эталонных тестов при машинном переводе. Большая ширина луча приводит к лучшей производительности модели, поскольку несколько последовательностей-кандидатов увеличивают вероятность лучшего совпадения целевой последовательности. Эта повышенная производительность приводит к снижению скорости декодирования.

В NMT новые предложения переводятся простым декодером поиска луча, который находит перевод, который приблизительно максимизирует условную вероятность обученной модели NMT.Стратегия поиска луча генерирует перевод слово за словом слева направо, сохраняя при этом фиксированное количество (луч) активных кандидатов на каждом временном шаге. Увеличивая размер луча, можно повысить эффективность трансляции за счет значительного снижения скорости декодера.

— Стратегии поиска луча для нейронного машинного перевода, 2017.

Процесс поиска может останавливаться для каждого кандидата отдельно либо по достижении максимальной длины, по достижению маркера конца последовательности, либо по достижению пороговой вероятности.

Приведем конкретный пример.

Мы можем определить функцию для выполнения поиска луча для заданной последовательности вероятностей и параметра ширины луча k . На каждом шаге каждая последовательность-кандидат дополняется всеми возможными следующими шагами. Каждый возможный шаг оценивается путем умножения вероятностей. Выбираются последовательности k с наиболее вероятными вероятностями, а все другие кандидаты удаляются. Затем процесс повторяется до конца последовательности.

Вероятности — это маленькие числа, и их умножение дает очень маленькие числа. Чтобы избежать потери значимости чисел с плавающей запятой, натуральный логарифм вероятностей суммируется, что позволяет сохранять числа больше и удобнее. Кроме того, поиск часто выполняется путем минимизации оценки. Эта последняя настройка означает, что мы можем отсортировать все последовательности-кандидаты в порядке возрастания по их баллам и выбрать первые k в качестве наиболее вероятных последовательностей-кандидатов.

Функция beam_search_decoder () ниже реализует декодер поиска луча.

# поиск луча def beam_search_decoder (данные, k): последовательности = [[список (), 0,0]] # пройдемся по каждому шагу последовательно для строки в данных: all_candidates = список () # развернуть каждого текущего кандидата для i в диапазоне (len (последовательности)): seq, score = последовательностей [i] для j в диапазоне (len (строка)): кандидат = [seq + [j], оценка — журнал (строка [j])] all_candidates.добавить (кандидат) # упорядочить всех кандидатов по баллам заказанный = отсортированный (all_candidates, key = lambda tup: tup [1]) # выберите k лучших последовательности = заказанные [: k] возвращаемые последовательности

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 14 | # поиск лучей def beam_search_decoder (data, k): последовательностей = [[list (), 0.0]] # пройти каждый шаг в последовательности для строки в данных: all_candidates = list () # развернуть каждого текущего кандидата для i в диапазоне (len (последовательности)): seq, оценка = последовательности [i] для j в диапазоне (len (строка)): кандидат = [seq + [j], оценка — журнал (строка [j])] all_candidates.append (кандидат) # упорядочить всех кандидатов по количеству баллов упорядочено = отсортировано (all_candidates, key = lambda tup: tup [1]) # выбрать k лучших последовательностей = упорядочено [: k] возвращаемых последовательностей |

Мы можем связать это вместе с образцами данных из предыдущего раздела и на этот раз вернуть 3 наиболее вероятные последовательности.

из журнала импорта математики из массива импорта numpy из numpy import argmax # поиск луча def beam_search_decoder (данные, k): последовательности = [[список (), 0,0]] # пройдемся по каждому шагу последовательно для строки в данных: all_candidates = список () # развернуть каждого текущего кандидата для i в диапазоне (len (последовательности)): seq, score = последовательностей [i] для j в диапазоне (len (строка)): кандидат = [seq + [j], оценка — журнал (строка [j])] all_candidates.добавить (кандидат) # упорядочить всех кандидатов по баллам заказанный = отсортированный (all_candidates, key = lambda tup: tup [1]) # выберите k лучших последовательности = заказанные [: k] возвращаемые последовательности # определяем последовательность из 10 слов над словарём из 5 слов данные = [[0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0.5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1]] данные = массив (данные) # декодировать последовательность результат = beam_search_decoder (данные, 3) # результат печати для seq в результате: печать (seq)

1 2 3 4 5 6 7 8 9 10 11 12 13 140002 18 19 20 21 22 23 24 25 26 27 28 29 30 000 000 34 35 36 37 38 39 | из журнала импорта math из массива импорта numpy из массива импорта numpy argmax # beam search def beam_search_decoder (data, k): последовательностей = [[list (), 0.0]] # пройти каждый шаг в последовательности для строки в данных: all_candidates = list () # развернуть каждого текущего кандидата для i в диапазоне (len (последовательности)): seq, оценка = последовательности [i] для j в диапазоне (len (строка)): кандидат = [seq + [j], оценка — журнал (строка [j])] all_candidates.append (кандидат) # упорядочить всех кандидатов по количеству баллов упорядочено = отсортировано (all_candidates, key = lambda tup: tup [1]) # выбрать k лучших последовательностей = упорядочено [: k] возвращаемых последовательностей # определить последовательность из 10 слов в словаре из 5 слов data = [[0.1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1], [0,1, 0,2, 0,3, 0,4, 0,5], [0,5, 0,4, 0,3, 0,2, 0,1]] данные = массив (данные) # последовательность декодирования результат = beam_search_decoder (data, 3) # print result для seq in result: print (seq) |

При выполнении примера печатаются как целочисленные последовательности, так и их логическая вероятность.

Поэкспериментируйте с разными значениями k.

[[4, 0, 4, 0, 4, 0, 4, 0, 4, 0], 6.931471805599453]

[[4, 0, 4, 0, 4, 0, 4, 0, 4, 1], 7.1546153563]

[[4, 0, 4, 0, 4, 0, 4, 0, 3, 0], 7.1546153563]

[[4, 0, 4, 0, 4, 0, 4, 0, 4, 0], 6.931471805599453] [[4, 0, 4, 0, 4, 0, 4, 0, 4, 1 ], 7.154615356 [[4, 0, 4, 0, 4, 0, 4, 0, 3, 0], 7.154615356 |

Дополнительная литература

Этот раздел предоставляет дополнительные ресурсы по теме, если вы хотите углубиться.

Сводка

В этом руководстве вы открыли для себя алгоритмы декодирования жадного поиска и поиска по лучу, которые можно использовать для решения задач генерации текста.

В частности, вы выучили:

- Проблема декодирования по задачам генерации текста.

- Алгоритм декодера жадного поиска и как его реализовать на Python.

- Алгоритм декодера поиска луча и как его реализовать на Python.

Есть вопросы?

Задайте свои вопросы в комментариях ниже, и я постараюсь ответить.

Разрабатывайте модели глубокого обучения для текстовых данных уже сегодня!

Разработка собственных текстовых моделей за считанные минуты

... всего несколькими строками кода Python

Узнайте, как это сделать, в моей новой электронной книге:

Deep Learning for Natural Language Processing

Он предоставляет самоучителей по таким темам, как:

Пакет слов, встраивание слов, языковые модели, создание титров, перевод текста и многое другое ...

Наконец-то привнесите глубокое обучение в свои проекты обработки естественного языка

Пропустить академики.Только результаты.

Посмотрите, что внутриРуководство по модели кодировщика-декодера и механизму внимания | Эдуардо Муньос

Как мы упоминали ранее, мы заинтересованы в групповом обучении сети; поэтому мы создаем функцию, которая выполняет обучение пакета данных:

- Вызвать кодировщик для последовательности пакетного ввода - на выходе будет закодированный вектор

- Установить начальные состояния декодера на закодированный вектор

- Вызов декодер, принимая в качестве входных данных целевую последовательность со смещением вправо.Выходные данные - логиты (функция softmax применяется в функции потерь).

- Вычислить потерю и точность пакетных данных

- Обновить обучаемые параметры кодера и декодера

- Обновить оптимизатор

Как вы можете заметить, наша функция поезда принимает три последовательности:

- Входная последовательность: массив целых чисел формы:

[batch_size, max_seq_len, embedding dim]. Это входная последовательность для кодировщика. - Целевая последовательность: Массив целых чисел формы:

[batch_size, max_seq_len, embedding dim].Это цель нашей модели, результат, который нам нужен для нашей модели. - Целевая входная последовательность: Массив целых чисел формы:

[batch_size, max_seq_len, embedding dim]. Это входная последовательность для декодера, потому что мы используем учитель, заставляющий .

Принуждение учителя

Принуждение учителя - это метод обучения, критически важный для разработки моделей глубокого обучения в НЛП. «Это способ быстрого и эффективного обучения повторяющихся моделей нейронных сетей, которые используют в качестве входных данных достоверную информацию из предыдущего временного шага.», [8]« Что учитель заставляет использовать рекуррентные нейронные сети? » Джейсон Браунли, доктор философии

В рекуррентной сети обычно входом в RNN на временном шаге t является выход RNN на предыдущем временном шаге, t-1. Но с помощью принуждения учителя мы можем использовать фактический результат для улучшения обучающих возможностей модели.

«Принуждение учителя работает с использованием фактических или ожидаемых выходных данных из набора обучающих данных на текущем временном шаге y (t) в качестве входных данных на следующем временном шаге X (t + 1), а не выходных данных, генерируемых сетью.

- «Глубокое обучение» Иэна Гудфеллоу

Итак, в нашем примере целевой вывод на временном шаге t является входом декодера на временном шаге t + 1. Наша входная последовательность для декодера будет ожидаемой целевой последовательностью, сдвинутой на одну позицию вправо. Для этого мы вставляем начальный токен последовательности в первую позицию, чтобы токен в позиции 1 переместился в позицию 2, токен с 2 по 3 и так далее. Чтобы уравнять длины последовательностей и разграничить их конец, в целевой последовательности мы поместим маркер конца последовательности в последнюю позицию.

Когда результат нашей модели не отличается от того, что было видно на модели во время обучения, принуждение учителя очень эффективно. Но если нам нужна более креативная модель, в которой при заданной входной последовательности может быть несколько возможных выходов, мы должны избегать этого метода или применять его случайным образом (только в некоторых случайных временных шагах).

Теперь мы можем закодировать основную функцию поезда:

Мы почти готовы - наш последний шаг включает вызов основной функции поезда, и мы создаем объект контрольной точки для сохранения нашей модели.Поскольку тренировочный процесс требует длительного времени, мы будем сохранять его каждые две эпохи. Позже мы сможем восстановить его и использовать для прогнозов.

Мы обучаем нашу модель кодировщика-декодера в течение ограниченного периода времени (примерно один час), используя 40 000 пар предложений и RNN из 512 единиц. Мы достигаем хороших результатов:

Делаем прогнозы

На этапе прогнозирования входными данными является последовательность длины один, токен sos . Затем мы повторно вызываем кодировщик и декодер, пока не получим токен eos или не достигнем максимальной заданной длины.

Вот несколько примеров полученных нами прогнозов:

[«мы не пойдем», «почему тебе грустно?»]

[«нет вамос.',' ¿por que estas triste? ']

Трансформаторные модели кодировщика-декодера

! Pip install трансформаторы == 4.2.1

! pip install фраза == 0.1.95

Модель кодера-декодера на основе трансформатора была представлена Васвани. и другие. в знаменитом Attention - это все, что вам нужно бумаги и сегодня это де-факто стандартная архитектура кодера-декодера при обработке естественного языка (НЛП).

В последнее время было проведено много исследований по разным предварительному обучению объективы для моделей кодеров-декодеров на базе трансформаторов, , например Т5, Барт, Пегас, ProphetNet, Мардж, и т. Д. ..., но модель архитектуры остался в основном прежним.

Цель сообщения в блоге - дать подробное объяснение как модели архитектуры кодера-декодера на основе трансформатора от последовательности к последовательности проблемы.Сфокусируемся на математической модели определяется архитектурой и тем, как модель может использоваться для вывода. Попутно мы дадим некоторую справочную информацию о последовательности в последовательность. модели в NLP и разбить кодировщик-декодер на базе трансформатора архитектура в его кодировщика и декодера частей. Мы предоставляем много иллюстрации и установить связь между теорией модели кодеров-декодеров на базе трансформаторов и их практическое применение в 🤗Трансформаторы для вывода.Обратите внимание, что это сообщение в блоге не объясняет , а не как такие модели можно обучить - это тема будущего блога Почта.

Модели кодировщиков-декодеров на базе трансформаторов являются результатом многолетней Исследование представлений , изучение архитектур моделей и . Этот Блокнот содержит краткое изложение истории нейронных кодировщики-декодеры модели. Для получения дополнительной информации читателю рекомендуется прочитать этот замечательный блог опубликовать Себастион Рудер. Кроме того, базовое понимание рекомендуется архитектура с самовниманием .Следующее сообщение в блоге автора Джей Аламмар служит хорошим напоминанием об оригинальной модели Transformer. здесь.

На момент написания этого блокнота «Трансформеры включают кодировщики-декодеры моделей T5 , Bart , MarianMT и Pegasus , которые кратко описаны в документации по модели резюме.

Ноутбук разделен на четыре части:

- Предпосылки - Краткая история моделей нейронных кодировщиков-декодеров дается с акцентом на модели на основе RNN.

- Кодер-декодер - Модель кодера-декодера на основе трансформатора представлена и объясняется, как модель используется для вывод.

- Энкодер - Часть модели энкодера объяснена в деталь.

- Декодер - Декодерная часть модели объяснена в деталь.

Каждая часть основана на предыдущей части, но также может быть прочитана на ее собственный.

ФонЗадачи генерации естественного языка (NLG), подполе NLP, являются лучшими выражаются как задачи от последовательности к последовательности.Такие задачи можно определить как поиск модели, которая отображает последовательность входных слов в последовательность целевые слова. Некоторые классические примеры - это суммирование и перевод . Далее мы предполагаем, что каждое слово закодировано в векторное представление. входные слова nnn могут быть представлены как последовательность входных векторов nnn:

X1: n = {x1,…, xn}. \ Mathbf {X} _ {1: n} = \ {\ mathbf {x} _1, \ ldots, \ mathbf {x} _n \}. X1: n = {x1,…, xn}.

Следовательно, проблемы от последовательности к последовательности могут быть решены путем нахождения отображение fff из входной последовательности nnn векторов X1: n \ mathbf {X} _ {1: n} X1: n в последовательность целевых векторов mmm Y1: m \ mathbf {Y} _ {1: m} Y1: m, тогда как число векторов-мишеней ммм априори неизвестен и зависит от входных данных последовательность:

f: X1: n → Y1: m.22 для решения задач от последовательности к последовательности следовательно, означает, что необходимо знать количество целевых векторов mmm apriori и должен быть независимым от ввода X1: n \ mathbf {X} _ {1: n} X1: n. Это неоптимально, потому что для задач в NLG количество целевых слов обычно зависит от ввода X1: n \ mathbf {X} _ {1: n} X1: n и не только на входной длине nnn. Например. , статья 1000 слов можно суммировать как до 200 слов, так и до 100 слов в зависимости от его содержание.

В 2014 г. Cho et al.33. После обработки последнего входного вектора xn \ mathbf {x} _nxn, Скрытое состояние кодировщика определяет входную кодировку c \ mathbf {c} c. Таким образом, кодировщик определяет отображение:

fθenc: X1: n → c. f _ {\ theta_ {enc}}: \ mathbf {X} _ {1: n} \ to \ mathbf {c}. fθenc: X1: n → c.

Затем скрытое состояние декодера инициализируется входной кодировкой. и во время логического вывода декодер RNN используется для авторегрессивного генерировать целевую последовательность. Поясним.

Математически декодер определяет распределение вероятностей целевая последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m с учетом скрытого состояния c \ mathbf {c} c:

pθdec (Y1: m∣c).{m} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}). pθdec (Y1: m ∣c) = i = 1∏m pθdec (yi ∣Y0: i − 1, c).

Таким образом, если архитектура может моделировать условное распределение следующий целевой вектор, учитывая все предыдущие целевые векторы:

pθdec (yi∣Y0: i − 1, c), ∀i∈ {1,…, m}, p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}), \ forall i \ in \ {1, \ ldots, m \}, pθdec (yi ∣Y0: i − 1, c), ∀ i∈ {1,…, m},

, то он может моделировать распределение любой последовательности целевого вектора, заданной скрытое состояние c \ mathbf {c} c путем простого умножения всех условных вероятности.

Так как же модель архитектуры декодера на основе RNN pθdec (yi∣Y0: i − 1, c) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ { 0: i-1}, \ mathbf {c}) pθdec (yi ∣Y0: i − 1, c)?

С точки зрения вычислений, модель последовательно отображает предыдущий внутренний скрытое состояние ci − 1 \ mathbf {c} _ {i-1} ci − 1 и предыдущий целевой вектор yi \ mathbf {y} _iyi до текущего внутреннего скрытого состояния ci \ mathbf {c} _ici и a вектор logit li \ mathbf {l} _ili (показано темно-красным цветом ниже):

fθdec (yi − 1, ci − 1) → li, ci.f _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _ {i-1}, \ mathbf {c} _ {i-1}) \ to \ mathbf {l} _i, \ mathbf {c } _i.fθdec (yi − 1, ci − 1) → li, ci. c0 \ mathbf {c} _0c0 таким образом определяется как c \ mathbf {c} c, являющийся выходом скрытое состояние кодировщика на основе RNN. Впоследствии softmax используется для преобразования вектора логита li \ mathbf {l} _ili в условное распределение вероятностей следующего целевого вектора:

p (yi∣li) = Softmax (li), где li = fθdec (yi − 1, cprev). p (\ mathbf {y} _i | \ mathbf {l} _i) = \ textbf {Softmax} (\ mathbf {l} _i), \ text {with} \ mathbf {l} _i = f _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _ {i-1}, \ mathbf {c} _ {\ text {prev}}).44. Из приведенного выше уравнения мы можно видеть, что распределение текущего целевого вектора yi \ mathbf {y} _iyi напрямую обусловлено предыдущим целевым вектором yi − 1 \ mathbf {y} _ {i-1} yi − 1 и предыдущим скрытым состоянием ci −1 \ mathbf {c} _ {i-1} ci − 1. Поскольку предыдущее скрытое состояние ci − 1 \ mathbf {c} _ {i-1} ci − 1 зависит от всех предыдущие целевые векторы y0,…, yi − 2 \ mathbf {y} _0, \ ldots, \ mathbf {y} _ {i-2} y0,…, yi − 2, он может быть заявлено, что декодер на основе RNN неявно ( например, косвенно ) моделирует условное распределение pθdec (yi∣Y0: i − 1, c) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}) pθdec (yi ∣Y0: i − 1, c).55, которые эффективно выбирают целевой вектор с высокой вероятностью последовательности из pθdec (Y1: m∣c) p _ {\ theta_ {dec}} (\ mathbf {Y} _ {1: m} | \ mathbf {c}) pθdec (Y1: m ∣c).

При таком методе декодирования во время вывода следующий входной вектор yi \ mathbf {y} _iyi может быть выбран из pθdec (yi∣Y0: i − 1, c) p _ {\ theta _ {\ text {dec}} } (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}) pθdec (yi ∣Y0: i − 1, c) и, следовательно, добавляется к входной последовательности, так что декодер Затем RNN моделирует pθdec (yi + 1∣Y0: i, c) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _ {i + 1} | \ mathbf {Y} _ {0: i }, \ mathbf {c}) pθdec (yi + 1 ∣Y0: i, c) для выборки следующего входного вектора yi + 1 \ mathbf {y} _ {i + 1} yi + 1 и т. д. в авторегрессивный мод.

Важной особенностью моделей кодеров-декодеров на основе RNN является определение специальных векторов , таких как вектор EOS \ text {EOS} EOS и BOS \ text {BOS} BOS. Вектор EOS \ text {EOS} EOS часто представляет собой окончательный входной вектор xn \ mathbf {x} _nxn, чтобы "указать" кодировщику, что вход последовательность закончилась, а также определяет конец целевой последовательности. В качестве как только EOS \ text {EOS} EOS выбирается из вектора логита, генерация завершено. Вектор BOS \ text {BOS} BOS представляет входной вектор y0 \ mathbf {y} _0y0, подаваемый в декодер RNN на самом первом этапе декодирования.Для вывода первого логита l1 \ mathbf {l} _1l1 требуется ввод, и поскольку на первом шаге не было создано никаких входных данных. специальный BOS \ text {BOS} BOS входной вектор поступает на декодер RNN. Хорошо - довольно сложно! Давайте проиллюстрируйте и рассмотрите пример.

Развернутый кодировщик RNN окрашен в зеленый цвет, а развернутый RNN декодер окрашен в красный цвет.

Английское предложение «Я хочу купить машину», представленное как x1 = I \ mathbf {x} _1 = \ text {I} x1 = I, x2 = want \ mathbf {x} _2 = \ text {want} x2 = хочу, x3 = to \ mathbf {x} _3 = \ text {to} x3 = to, x4 = buy \ mathbf {x} _4 = \ text {buy} x4 = buy, x5 = a \ mathbf {x} _5 = \ text {a} x5 = a, x6 = car \ mathbf {x} _6 = \ text {car} x6 = car и x7 = EOS \ mathbf {x} _7 = \ text {EOS} x7 = EOS переводится на немецкий: "Ich will ein Auto kaufen "определяется как y0 = BOS \ mathbf {y} _0 = \ text {BOS} y0 = BOS, y1 = Ich \ mathbf {y} _1 = \ text {Ich} y1 = Ich, y2 = will \ mathbf {y} _2 = \ text {will} y2 = will, y3 = ein \ mathbf {y} _3 = \ text {ein} y3 = ein, y4 = Auto, y5 = kaufen \ mathbf {y} _4 = \ text {Auto}, \ mathbf {y} _5 = \ text {kaufen} y4 = Auto, y5 = kaufen и y6 = EOS \ mathbf {y} _6 = \ text {EOS} y6 = EOS. 66.На рисунке выше горизонтальная стрелка, соединяющая развернутый кодировщик RNN представляет собой последовательные обновления скрытых штат. Окончательное скрытое состояние кодировщика RNN, представленное c \ mathbf {c} c, затем полностью определяет кодировку входных данных. последовательность и используется как начальное скрытое состояние декодера RNN. Это можно увидеть как преобразование декодера RNN на закодированный вход.

Для генерации первого целевого вектора в декодер загружается BOS \ text {BOS} BOS вектор, показанный как y0 \ mathbf {y} _0y0 на рисунке выше.Цель вектор RNN затем дополнительно преобразуется в вектор логита l1 \ mathbf {l} _1l1 с помощью уровня прямой связи LM Head для определения условное распределение первого целевого вектора, как объяснено выше:

pθdec (y∣BOS, c). p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS}, \ mathbf {c}). pθdec (y∣BOS, c).

Выбирается слово Ich \ text {Ich} Ich (показано серой стрелкой, соединяющей l1 \ mathbf {l} _1l1 и y1 \ mathbf {y} _1y1) и, следовательно, вторая цель вектор может быть выбран:

будет ∼pθdec (y∣BOS, Ich, c).\ text {will} \ sim p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS}, \ text {Ich}, \ mathbf {c}). will∼pθdec (y∣BOS, Ich, c).

И так далее, пока на шаге i = 6i = 6i = 6, вектор EOS \ text {EOS} EOS не будет выбран из l6 \ mathbf {l} _6l6, и декодирование не будет завершено. Результирующая цель последовательность составляет Y1: 6 = {y1,…, y6} \ mathbf {Y} _ {1: 6} = \ {\ mathbf {y} _1, \ ldots, \ mathbf {y} _6 \} Y1: 6 = {y1,…, y6}, что является «Ich will ein Auto kaufen» в нашем примере выше.

Подводя итог, модель кодера-декодера на основе RNN, представленная fθencf _ {\ theta _ {\ text {enc}}} fθenc и pθdec p _ {\ theta _ {\ text {dec}}} pθdec, определяет распределение p (Y1: m∣X1: n) p (\ mathbf {Y} _ {1: m} | \ mathbf {X} _ {1: n}) p (Y1: m ∣X1: n) к факторизация:

pθenc, θdec (Y1: m∣X1: n) = ∏i = 1mpθenc, θdec (yi∣Y0: i − 1, X1: n) = ∏i = 1mpθdec (yi∣Y0: i − 1, c), с c = fθenc (X).{m} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {c}), \ text {with} \ mathbf {c} = f _ {\ theta_ {enc}} (X). pθenc, θdec (Y1: m ∣X1: n) = i = 1∏m pθenc, θdec (yi ∣Y0: i − 1, X1: n) = i = 1 ∏m pθdec (yi ∣Y0: i − 1, c), где c = fθenc (X).

Во время вывода эффективные методы декодирования могут авторегрессивно сгенерировать целевую последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m.

Модель кодера-декодера на основе RNN взяла штурмом сообщество NLG. В В 2016 г. компания Google объявила о полной замене разработанной услуги перевода с помощью единой модели кодировщика-декодера на основе RNN (см. здесь).44 Нейронная сеть может определять распределение вероятностей по всем слова, , т.е. p (y∣c, Y0: i − 1) p (\ mathbf {y} | \ mathbf {c}, \ mathbf {Y} _ {0: i-1}) p (y∣c , Y0: i − 1) как следует. Сначала сеть определяет отображение входов c, Y0: i − 1 \ mathbf {c}, \ mathbf {Y} _ {0: i-1} c, Y0: i − 1 во встроенное векторное представление y ′ \ Mathbf {y '} y ′, что соответствует целевому вектору RNN. Встроенный векторное представление y ′ \ mathbf {y '} y ′ затем передается на "язык модель головы ", что означает, что он умножается на слова. матрица внедрения , i.66 Sutskever et al. (2014) меняет порядок ввода так, чтобы в приведенном выше примере ввод векторы будут соответствовать x1 = car \ mathbf {x} _1 = \ text {car} x1 = car, x2 = a \ mathbf {x} _2 = \ text {a} x2 = a, x3 = buy \ mathbf { x} _3 = \ text {buy} x3 = buy, x4 = to \ mathbf {x} _4 = \ text {to} x4 = to, x5 = want \ mathbf {x} _5 = \ text {want} x5 = Хочу, x6 = I \ mathbf {x} _6 = \ text {I} x6 = I и x7 = EOS \ mathbf {x} _7 = \ text {EOS} x7 = EOS. В мотивация состоит в том, чтобы обеспечить более короткую связь между соответствующими пары слов, такие как x6 = I \ mathbf {x} _6 = \ text {I} x6 = I и y1 = Ich \ mathbf {y} _1 = \ text {Ich} y1 = Ich.Исследовательская группа подчеркивает, что обращение входной последовательности было ключевой причиной того, что их модель улучшена производительность машинного перевода.

Кодер-декодерВ 2017 г. Vaswani et al. представил трансформатор Transformer и тем самым дал рождение модели на базе трансформатора кодировщика-декодера .

Аналогичен моделям кодировщика-декодера на базе RNN, трансформаторный Модели кодировщика-декодера состоят из кодировщика и декодера, которые обе стопки из блоков остаточного внимания .Ключевое новшество трансформаторные модели кодировщика-декодера заключается в том, что такое остаточное внимание блоки могут обрабатывать входную последовательность X1: n \ mathbf {X} _ {1: n} X1: n переменной длина nnn без отображения повторяющейся структуры. Не полагаясь на рекуррентная структура позволяет преобразовывать кодировщики-декодеры высокая степень распараллеливания, что делает модель на порядки больше вычислительно эффективен, чем модели кодировщика-декодера на основе RNN на современное оборудование.

Напоминаем, что для решения задачи от последовательности к последовательности нам необходимо найти отображение входной последовательности X1: n \ mathbf {X} _ {1: n} X1: n на выход последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m переменной длины mmm.Посмотрим как модели кодеров-декодеров на основе трансформаторов используются для поиска такого отображение.

Подобно моделям кодировщика-декодера на основе RNN, трансформатор на основе модели кодировщика-декодера определяют условное распределение целевых векторы Y1: n \ mathbf {Y} _ {1: n} Y1: n с заданной входной последовательностью X1: n \ mathbf {X} _ {1: n} X1: n:

pθenc, θdec (Y1: m∣X1: n). p _ {\ theta _ {\ text {enc}}, \ theta _ {\ text {dec}}} (\ mathbf {Y} _ {1: m} | \ mathbf {X} _ {1: n}). pθenc, θdec (Y1: m ∣X1: n).

Кодер на основе трансформатора кодирует входную последовательность X1: n \ mathbf {X} _ {1: n} X1: n в последовательность из скрытых состояний X‾1: n \ mathbf {\ overline { X}} _ {1: n} X1: n, таким образом определяя отображение:

fθenc: X1: n → X‾1: n.f _ {\ theta _ {\ text {enc}}}: \ mathbf {X} _ {1: n} \ to \ mathbf {\ overline {X}} _ {1: n}. fθenc: X1: n → X1: n.

Часть декодера на основе трансформатора затем моделирует условное распределение вероятностей последовательности целевых векторов Y1: n \ mathbf {Y} _ {1: n} Y1: n с учетом последовательности закодированных скрытых состояний X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n:

pθdec (Y1: n∣X‾1: n). p _ {\ theta_ {dec}} (\ mathbf {Y} _ {1: n} | \ mathbf {\ overline {X}} _ {1: n}). pθdec (Y1: n ∣X1: n ).

По правилу Байеса это распределение можно разложить на множители условное распределение вероятностей целевого вектора yi \ mathbf {y} _iyi учитывая закодированные скрытые состояния X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n и все предыдущие целевые векторы Y0: i − 1 \ mathbf {Y} _ {0: i-1} Y0: i − 1:

pθdec (Y1: n∣X‾1: n) = ∏i = 1npθdec (yi∣Y0: i − 1, X‾1: n).{n} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}). pθdec (Y1: n ∣X1: n) = i = 1∏n pθdec (yi ∣Y0: i − 1, X1: n).

Трансформаторный декодер тем самым отображает последовательность закодированных скрытых указывает X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n и все предыдущие целевые векторы Y0: i − 1 \ mathbf {Y} _ {0: i-1} Y0: i − 1 в вектор logit li \ mathbf {l} _ili. Логит вектор li \ mathbf {l} _ili затем обрабатывается операцией softmax для определить условное распределение pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i -1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n), так же, как это делается для декодеров на основе RNN.Однако в отличие от Декодеры на основе RNN, распределение целевого вектора yi \ mathbf {y} _iyi явно (или напрямую) обусловлено всеми предыдущими целевыми векторами y0,…, yi − 1 \ mathbf {y} _0, \ ldots, \ mathbf {y} _ {i-1} y0,…, yi − 1 Как мы увидим позже деталь. 0-й целевой вектор y0 \ mathbf {y} _0y0 настоящим представлен специальный "начало предложения" BOS \ text {BOS} вектор BOS.

Определив условное распределение pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0 : i-1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n), теперь мы можем авторегрессивно сгенерировать вывод и таким образом определить отображение входной последовательности X1: n \ mathbf {X} _ {1: n} X1: n в выходную последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m при выводе.

Давайте визуализируем полный процесс авторегрессивной генерации модели кодеров-декодеров на базе трансформатора.

Трансформаторный энкодер окрашен в зеленый цвет, а Трансформаторный декодер окрашен в красный цвет. Как и в предыдущем разделе, мы показываем, как английское предложение «Я хочу купить машину», представленное как x1 = I \ mathbf {x} _1 = \ text {I} x1 = I, x2 = want \ mathbf {x} _2 = \ text { want} x2 = want, x3 = to \ mathbf {x} _3 = \ text {to} x3 = to, x4 = buy \ mathbf {x} _4 = \ text {buy} x4 = buy, x5 = a \ mathbf {x} _5 = \ text {a} x5 = a, x6 = car \ mathbf {x} _6 = \ text {car} x6 = car и x7 = EOS \ mathbf {x} _7 = \ text {EOS} x7 = EOS переводится на немецкий: "Ich will ein Auto kaufen "определяется как y0 = BOS \ mathbf {y} _0 = \ text {BOS} y0 = BOS, y1 = Ich \ mathbf {y} _1 = \ text {Ich} y1 = Ich, y2 = will \ mathbf {y} _2 = \ text {will} y2 = will, y3 = ein \ mathbf {y} _3 = \ text {ein} y3 = ein, y4 = Auto, y5 = kaufen \ mathbf {y} _4 = \ text {Auto}, \ mathbf {y} _5 = \ text {kaufen} y4 = Auto, y5 = kaufen и y6 = EOS \ mathbf {y} _6 = \ text {EOS} y6 = EOS.

Сначала кодировщик обрабатывает всю входную последовательность X1: 7 \ mathbf {X} _ {1: 7} X1: 7 = «Я хочу купить машину» (представлен светом зеленые векторы) в контекстуализированную кодированную последовательность X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7. Например. x‾4 \ mathbf {\ overline {x}} _ 4x4 определяет кодировка, которая зависит не только от ввода x4 \ mathbf {x} _4x4 = "buy", но и все остальные слова «я», «хочу», «к», «а», «машина» и «EOS», , то есть контекст.

Затем входная кодировка X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7 вместе с BOS вектор, i.е. y0 \ mathbf {y} _0y0, подается на декодер. Декодер обрабатывает входные данные X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7 и y0 \ mathbf {y} _0y0, чтобы первый логит l1 \ mathbf {l} _1l1 (показан более темным красным) для определения условное распределение первого целевого вектора y1 \ mathbf {y} _1y1:

pθenc, dec (y∣y0, X1: 7) = pθenc, dec (y∣BOS, я хочу купить автомобиль EOS) = pθdec (y∣BOS, X‾1: 7). p _ {\ theta_ {enc, dec}} (\ mathbf {y} | \ mathbf {y} _0, \ mathbf {X} _ {1: 7}) = p _ {\ theta_ {enc, dec}} (\ mathbf {y} | \ text {BOS}, \ text {Я хочу купить машину EOS}) = p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS}, \ mathbf {\ overline { X}} _ {1: 7}).pθenc, dec (y∣y0, X1: 7) = pθenc, dec (y∣BOS, я хочу купить машину EOS) = pθdec (y∣BOS, X1: 7).

Затем выбирается первый целевой вектор y1 \ mathbf {y} _1y1 = Ich \ text {Ich} Ich из распределения (обозначено серыми стрелками) и теперь может быть снова подается на декодер. Теперь декодер обрабатывает как y0 \ mathbf {y} _0y0 = "BOS" и y1 \ mathbf {y} _1y1 = "Ich" для определения условного распределение второго целевого вектора y2 \ mathbf {y} _2y2:

pθdec (y∣BOS Ich, X‾1: 7). p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS Ich}, \ mathbf {\ overline {X}} _ {1: 7}).pθdec (y∣BOS Ich, X1: 7).

Мы можем снова выполнить выборку и создать целевой вектор y2 \ mathbf {y} _2y2 = "буду". Мы продолжаем в авторегрессивном режиме до тех пор, пока на шаге 6 не появится EOS. вектор выбирается из условного распределения:

EOS∼pθdec (y∣BOS Ich will ein Auto kaufen, X‾1: 7). \ text {EOS} \ sim p _ {\ theta_ {dec}} (\ mathbf {y} | \ text {BOS Ich будет ein Auto kaufen}, \ mathbf {\ overline {X}} _ {1: 7}). EOS∼pθdec (y∣BOS Ich будет ein Auto kaufen, X1: 7).

И так далее в авторегрессивном режиме.

Важно понимать, что энкодер используется только в первом прямой переход к карте X1: n \ mathbf {X} _ {1: n} X1: n в X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n. Начиная со второго прямого прохода, декодер может напрямую использовать ранее рассчитанная кодировка X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n. Для ясности, давайте проиллюстрируем первый и второй прямой проход для нашего пример выше.

Как видно, только на шаге i = 1i = 1i = 1 мы должны кодировать "Я хочу купить автомобиль EOS "на X‾1: 7 \ mathbf {\ overline {X}} _ {1: 7} X1: 7.На шаге i = 2i = 2i = 2 контекстные кодировки "Я хочу купить машину EOS" просто повторно используется декодером.

В 🤗Трансформаторах это авторегрессивное поколение выполняется под капотом.

при вызове метода .generate () . Воспользуемся одним из наших переводов

модели, чтобы увидеть это в действии.

из трансформаторов импортных MarianMTModel, MarianTokenizer

tokenizer = MarianTokenizer.from_pretrained («Хельсинки-НЛП / opus-mt-en-de»)

model = MarianMTModel.from_pretrained ("Хельсинки-НЛП / opus-mt-en-de")

input_ids = tokenizer («Я хочу купить машину», return_tensors = «pt»).input_ids

output_ids = model.generate (input_ids) [0]

печать (tokenizer.decode (output_ids))

Выход:

Ich will ein Auto kaufen

Вызов .generate () делает многие вещи скрытыми. Сначала проходит input_ids в кодировщик. Во-вторых, он передает предварительно определенный токен, которым является символ MarianMTModel вместе с закодированными input_ids для декодера.11. Более подробно о том, как работает декодирование с поиском луча, можно

посоветовал прочитать этот блог

Почта.

В приложение мы включили фрагмент кода, который показывает, как простая Метод генерации может быть реализован «с нуля». Чтобы полностью понять, как авторегрессивное поколение работает под капотом, это Настоятельно рекомендуется прочитать Приложение.

Подводя итог:

- Трансформаторный энкодер определяет отображение от входа последовательность X1: n \ mathbf {X} _ {1: n} X1: n в контекстуализированную последовательность кодирования X‾1: n \ mathbf {\ overline {X}} _ {1: n} X1: n.

- Трансформаторный декодер определяет условное распределение pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf {Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n).

- При соответствующем механизме декодирования выходная последовательность Y1: m \ mathbf {Y} _ {1: m} Y1: m может автоматически выбираться из pθdec (yi∣Y0: i − 1, X‾1: n), ∀i∈ {1,…, m} p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf { Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}), \ forall i \ in \ {1, \ ldots, m \} pθdec (yi ∣ Y0: i − 1, X1: n), ∀i∈ {1,…, m}.

Отлично, теперь, когда мы получили общий обзор того, как

Модели кодировщиков-декодеров на базе трансформатора работают, мы можем глубже погрузиться в

как кодировщик, так и декодер части модели. В частности, мы

увидит, как именно кодировщик использует слой самовнимания

чтобы получить последовательность контекстно-зависимых векторных кодировок и как

Уровни самовнимания позволяют эффективно распараллеливать. Тогда мы будем

подробно объясните, как слой самовнимания работает в декодере

модель и как декодер зависит от выхода кодировщика с перекрестного внимания слоев для определения условного распределения pθdec (yi∣Y0: i − 1, X‾1: n) p _ {\ theta _ {\ text {dec}}} (\ mathbf {y} _i | \ mathbf { Y} _ {0: i-1}, \ mathbf {\ overline {X}} _ {1: n}) pθdec (yi ∣Y0: i − 1, X1: n).11 В случае "Helsinki-NLP / opus-mt-en-de" декодирование

параметры доступны

здесь,

где мы видим, что модель применяет поиск луча с num_beams = 6 .

Как упоминалось в предыдущем разделе, энкодер на базе трансформатора сопоставляет входную последовательность с контекстной последовательностью кодирования: